OpenPose的行为识别OpenPose地址

1.权重包的下载

BODY25

1 | http://posefs1.perception.cs.cmu.edu/OpenPose/models/pose/body_25/pose_iter_584000.caffemodel |

COCO

1 | http://posefs1.perception.cs.cmu.edu/OpenPose/models/pose/coco/pose_iter_440000.caffemodel |

MPI

1 | http://posefs1.perception.cs.cmu.edu/OpenPose/models/pose/mpi/pose_iter_160000.caffemodel |

face

1 | http://posefs1.perception.cs.cmu.edu/OpenPose/models/face/pose_iter_116000.caffemodel |

hand

1 | http://posefs1.perception.cs.cmu.edu/OpenPose/models/hand/pose_iter_102000.caffemodel |

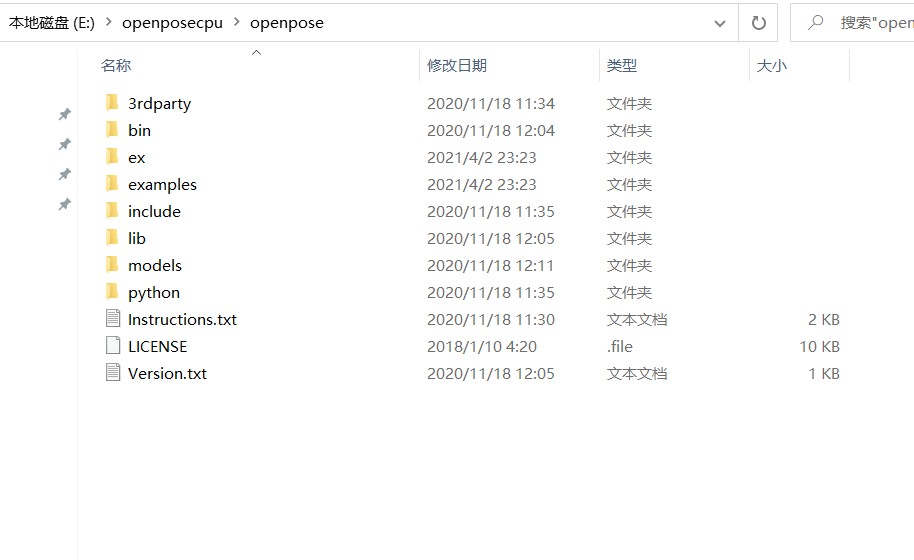

2.简单的使用

在此目录下使用命令,linux和Windows都是一样的,只需要简单的换一下最开始的调用程序就可以了。

1 | :: Windows - Portable Demo |

1 | # Ubuntu |

如果要检测手和脸

1 | bin\OpenPoseDemo.exe --video examples\media\video.avi --face --hand |

3.设置图片或者视频输出结果视频

保存图像

1 | bin/OpenPoseDemo.exe --image_dir examples/media/ --write_images examples/media_out/ |

保存json文件,即为人体骨骼姿态的关节点数据文件

1 | bin/OpenPoseDemo.exe --image_dir examples/media/ --write_keypoint_json examples/media_out/ |

保存yml文件,即为人体骨骼姿态的关节点数据文件

1 | bin/OpenPoseDemo.exe --image_dir examples/media/ --write_keypoint examples/media_out/ |

4.注意事项

行为识别的算法和CNN都很复杂,识别一张正常的图片只用我的9400都要12s,建议调用显卡,显存至少4G以上,如果是识别视频,可以将视频拆成图片然后再进行一个识别,都是这样做的。

5.视频的拆分和合上

这里使用Python和Opencv(为什么Python,当然是简单,如果使用其他语言和Opencv也不是不可以,只不过会很复杂)为了保证图片在下面,程序命名采用A_xxx.py的命名方式,代码如下:

1 | # A_togther.py照片的合并 |

1 | # A_split.py视频的分割 |

1 | # A_Change.py,这里是因为另外一个项目需要将视频进行二值化,网上找了一下程序没有找到 |

- 本文作者: windfill

- 本文链接: https://windfill.github.io/article/f49ddd65.html

- 版权声明: 本作品采用 CC BY-NC-SA 4.0 许可协议进行许可,转载请注明出处!